Alla scoperta delle norme dedicate all’intelligenza artificiale

I requisiti dei sistemi ad alto rischio

La scorsa settimana abbiamo visto le tipologie di modelli e di sistemi che il Regolamento europeo classifica come ad alto rischio.

Gli articoli 8 e seguenti stabiliscono i requisiti che essi devono avere.

Conformità

Come già accennato, innanzitutto, sono i fornitori stessi che hanno la responsabilità di “garantire che il loro prodotto sia pienamente conforme”.

L’articolo introduce una misura di flessibilità, consentendo ai fornitori di integrare alcuni degli obblighi nelle procedure e nella documentazione già esistenti: essi possono infatti, al fine di ottemperare, incorporare i processi di prova, comunicazione, informazioni e documentazione richiesti dall’AI Act all’interno delle procedure già stabilite da altre normative UE di armonizzazione (come sappiamo, tipicamente le procedure richieste dall’UE includono requisiti per la progettazione, la produzione, i test di sicurezza, la documentazione tecnica e le informazioni da fornire ai consumatori, come quelle che consentono di ottenere il marchio CE, che indica la conformità agli standard UE).

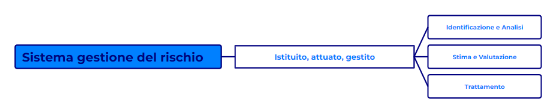

Sistema di gestione dei rischi

Il fornitore di un sistema ad alto rischio deve istituire, attuare, documentare e mantenere un sistema di gestione dei rischi che sia costituito come un processo iterativo, continuo, pianificato ed eseguito nel corso dell’intero ciclo di vita del modello o del sistema.

Come previsto dai più noti framework di gestione del rischio (management, assessment, ecc.), dovrà essere implementato per fasi:

- identificazione e analisi dei rischi noti e ragionevolmente prevedibili per la salute, la sicurezza, i diritti fondamentali quando il sistema è utilizzato conformemente alla sua finalità prevista;

- stima e valutazione dei rischi che possono emergere;

- valutazione di eventuali altri rischi;

- adozione di misure di gestione opportune e mirate.

Queste misure devono ridurre al minimo i rischi, in modo tale che il rischio residuo del sistema ad alto rischio possa essere considerato accettabile.

Nell’individuare tali misure il Regolamento richiede inoltre che siano garantite:

- l’eliminazione o la riduzione dei rischi mediante una adeguata progettazione e fabbricazione;

- l’attuazione di misure anche qui adeguate laddove i rischi non possano essere completamente eliminati;

- la fornitura di appropriate informazioni a coloro che utilizzeranno i sistemi, ossia i deployer.

A questo riguardo il fornitore dovrà tenere in debita considerazione le conoscenze tecniche, l’esperienza e la formazione che ci si può aspettare da chi utilizzerà i modelli.

Non per ultime, saranno necessarie apposite prove, anche in condizioni reali, per individuare le misure più appropriate.

Tutto ciò, come si vede, impone (peraltro in base al punto 8 dell’art. 9 che stiamo analizzando), che le analisi e le valutazioni dovranno essere eseguite prima della immissione sul mercato o della messa in servizio.

L’idea è dunque quella di affrontare il rischio in modo strutturato e sistematico, mediante

- ’identificazione e analisi dei rischi e, quindi, la disamina del contesto, dove si individueranno i potenziali pericoli associati all’uso del sistema IA (per esempio, per un sistema AI di diagnosi medica, si potrebbe identificare il rischio di diagnosi errate che portino a trattamenti inadeguati);

- stima e valutazione dei rischi, che implica la quantificazione della probabilità e dell’impatto dei rischi identificati (il rischio di una diagnosi errata potrebbe avere una probabilità di un certo grado e un impatto potenzialmente grave sulla salute del paziente);

- valutazione di eventuali altri rischi, considerando rischi meno ovvi o indiretti;

- adozione di misure di gestione, ossia implementazione di controlli e procedure per mitigare i rischi identificati (in un sistema di selezione del personale, si potrebbero introdurre revisioni umane delle decisioni e test regolari per il bias algoritmica);

- riduzione al minimo dei rischi, per portarli a un livello considerato “accettabile” secondo gli standard del settore e le normative (in un sistema per il controllo del traffico aereo, il rischio residuo potrebbe essere considerato accettabile se è inferiore a quello dei sistemi tradizionali e se sono in atto robusti sistemi di backup).

Come si vede, si tratta di un approccio che richiede ai fornitori di essere proattivi, mediante l’adozione di processi di risk management iterativi e costanti senza, peraltro, fornire una metodologia unica o specifica per procedere.

Ci occuperemo di questo argomento in una prossima uscita.

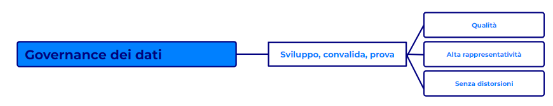

Governance dei dati

I fornitori devono garantire l’implementazione di metodologie e tecniche di governance dei dati, ossia di gestione degli stessi: si tratta di metodologie, processi e procedure che devono essere adottate nelle fasi di addestramento, convalida e prova.

I set di dati per l’addestramento, la convalida e il test devono innanzitutto soddisfare criteri di qualità specifici e tutto lo sviluppo deve essere improntato a scelte definite, in relazione a: progetto, processi di raccolta e origine dei dati, operazioni di trattamento (es. annotazione, etichettatura, pulizia), formulazione di ipotesi, valutazione della disponibilità e adeguatezza, esame delle possibili distorsioni, misure per prevenire e attenuare le distorsioni, identificazione e gestione di lacune.

I set di dati devono essere pertinenti, rappresentativi, possibilmente privi di errori e completi per lo scopo previsto e tenere conto delle caratteristiche specifiche dell’ambito in cui il sistema di IA sarà utilizzato.

In casi eccezionali, per rilevare e correggere distorsioni, possono essere trattate categorie particolari di dati personali, ma con rigide condizioni (necessità dimostrata, limitazioni tecniche al riutilizzo, misure di sicurezza avanzate, accesso limitato e controllato, divieto di trasferimento a terzi, cancellazione dopo l’uso, documentazione dettagliata del trattamento).

Questi requisiti si applicano principalmente ai sistemi che utilizzano tecniche di apprendimento automatico. Per i sistemi che non utilizzano tali tecniche, solo i set di dati di test sono soggetti a questi requisiti.

In sintesi, queste disposizioni mirano a garantire che i sistemi ad alto rischio siano sviluppati utilizzando dati di alta qualità, rappresentativi e privi di distorsioni, con un’attenzione particolare alla protezione dei dati personali e alla prevenzione di discriminazioni.

L’obiettivo è assicurare che questi sistemi siano affidabili, equi e sicuri quando vengono utilizzati in contesti che possono avere un impatto significativo sulla vita delle persone.

Documentazione tecnica

La documentazione deve avere le caratteristiche e i contenuti indicati nell’Allegato IV. Fondamentalmente deve fornire una panoramica completa del sistema di IA, includendo specifiche che vanno dallo sviluppo al funzionamento, ivi compresi aspetti di sicurezza, conformità e monitoraggio continuo.

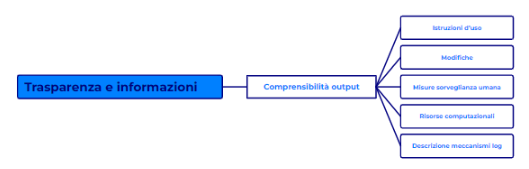

Conservazione dei log

Si tratta di requisiti che mirano a garantire la trasparenza, la responsabilità e la tracciabilità del funzionamento dei sistemi di IA ad alto rischio, con particolare attenzione ai sistemi utilizzati nell’ambito dell’applicazione della legge.

Essi, in particolare, devono consentire, tecnicamente:

- la registrazione automatica degli eventi (log) durante tutto il loro ciclo di vita. Ciò allo scopo di:

- individuare situazioni di rischio o modifiche sostanziali;

- facilitare il monitoraggio post-commercializzazione;

- monitorare il funzionamento del sistema;

- i sistemi di identificazione biometrica, inoltre, laddove utilizzati in applicazione della legge, devono prevedere la conservazione dei log relativi a:

- la registrazione del periodo di utilizzo (inizio e fine),

- la banca dati di riferimento utilizzata per la verifica dei dati di input;

- i dati di input che hanno portato a una corrispondenza;

- l’identificativo delle persone fisiche coinvolte nella verifica dei risultati.

Trasparenza

I sistemi ad alto rischio devono essere progettati e sviluppati in modo tale da garantire che il loro funzionamento sia sufficientemente trasparente da consentire ai deployer di interpretare l’output del sistema e utilizzarlo adeguatamente.

Devono essere dotati di istruzioni d’uso con informazioni concise ma complete, chiare e pertinenti, per i deployer, che contengano:

- dati di contatto del fornitore;

- caratteristiche e capacità dei sistemi (finalità, livello di accuratezza, circostanze che potrebbero comportare rischi);

- risorse e capacità;

- ogni informazione utile.

Sorveglianza umana

I requisiti relativi alla sorveglianza umana mirano a garantire che, nonostante l’autonomia che i sistemi ad alto rischio possano avere, ci sia sempre un controllo umano significativo.

L’obiettivo è, evidentemente, quello di bilanciare i benefici dell’automazione con la necessità di supervisione umana per prevenire errori, bias o decisioni potenzialmente dannose.

La flessibilità nelle misure di sorveglianza permette di adattarle al contesto specifico di utilizzo del sistema.

Tali sistemi devono quindi:

- essere progettati per consentire la supervisione umana durante il loro utilizzo, di modo che siano ridotti i rischi;

- la supervisione deve essere tale da far comprendere capacità e limiti del sistema e consentire il monitoraggio del funzionamento, anche in relazione ad eventuali anomalie;

- fare in modo che si possa mantenere consapevolezza del fatto che sia comune fare affidamento eccessivo sugli output, laddove essi forniscano raccomandazioni e suggerimenti su decisioni da intraprendere;

- dare la possibilità di ignorare, annullare o ribaltare gli output del sistema;

- prevedere un meccanismo, o un pulsante, che consenta di arrestare il sistema in condizioni di sicurezza.

- devono includere interfacce uomo-macchina adeguate.

- I sistemi che utilizzano la biometria devono prevedere una verifica e conferma dell’identificazione da parte di almeno due persone fisiche qualificate.

Accuratezza, robustezza, cybersicurezza

Infine, i sistemi ad alto rischio devono ovviamente essere progettati e sviluppati in modo tale da conseguire un adeguato livello di accuratezza, robustezza e cybersicurezza e nonché per operare in modo coerente con tali aspetti durante tutto il loro ciclo di vita.

Tali livelli devono essere documentati e dichiarati nelle istruzioni d’uso.

Molti sistemi avanzati sono progettati per “imparare” continuamente dall’esperienza.

Questo apprendimento continuo può migliorare le prestazioni nel tempo, ma presenta anche rischi.

Rischio di distorsioni (bias) nei circuiti di feedback:

Un “circuito di feedback” si verifica quando l’output del sistema influenza i suoi input futuri. I sistemi devono essere progettati per ridurre al minimo tali rischi.

Essi devono, inoltre, essere resilienti rispetto ai tentativi di modificarne gli usi, gli output o le prestazioni.

Devono, poi, essere implementate tecniche finalizzate a minimizzare o eliminare le specifiche vulnerabilità dei sistemi di AI.

Su tali possibili misure torneremo.

Il riassunto (questa settimana di ChatGPT 4o) del testo 😛

Conformità

I fornitori sono responsabili di garantire la piena conformità dei loro prodotti, integrando gli obblighi del regolamento nelle procedure esistenti per ottenere il marchio CE.

Sistema di gestione dei rischi

I fornitori devono istituire un sistema iterativo e continuo di gestione dei rischi per l’intero ciclo di vita del sistema, implementando fasi di identificazione, stima, valutazione e gestione dei rischi. Devono ridurre al minimo i rischi residui, garantendo eliminazione o riduzione dei rischi, attuazione di misure adeguate e fornendo informazioni appropriate agli utenti.

Governance dei dati

I fornitori devono implementare metodologie di governance dei dati durante le fasi di addestramento, convalida e prova, garantendo che i set di dati siano di alta qualità, rappresentativi e privi di distorsioni. È necessario garantire la protezione dei dati personali e prevenire discriminazioni.

Documentazione tecnica

La documentazione deve essere completa e includere tutte le specifiche del sistema, dalla progettazione al funzionamento, conformità e monitoraggio continuo.

Conservazione dei log

I sistemi devono registrare automaticamente gli eventi durante tutto il ciclo di vita per garantire trasparenza, responsabilità e tracciabilità, specialmente per i sistemi utilizzati nell’applicazione della legge.

Trasparenza

I sistemi devono essere progettati per garantire trasparenza nel loro funzionamento, fornendo istruzioni d’uso chiare e complete per consentire ai deployer di interpretare e utilizzare correttamente gli output del sistema.

Sorveglianza umana

I sistemi ad alto rischio devono consentire una supervisione umana significativa per prevenire errori, bias e decisioni dannose. Devono includere interfacce uomo-macchina adeguate e meccanismi di arresto sicuro.

Accuratezza, robustezza, cybersicurezza

I sistemi devono essere progettati per garantire livelli adeguati di accuratezza, robustezza e cybersicurezza, documentati nelle istruzioni d’uso. Devono ridurre al minimo i rischi di distorsioni nei circuiti di feedback e essere resilienti contro tentativi di modifica delle prestazioni.

👾

p.s.: come sempre, ogni suggerimento o correzione, come sempre, è più che ben accetta!

👾 👾 👾 👾 👾

Questa newsletter si propone di esaminare le principali disposizioni in arrivo con un linguaggio semplice e chiaro, accompagnato il più possibile da esempi concreti.

Se sei interessato, iscriviti. 👾