Alla scoperta delle norme dedicate all’intelligenza artificiale

I sistemi ad alto rischio

Questa newsletter si propone di esaminare il Regolamento Europeo in materia di Intelligenza Artificiale con brevi articoli settimanali (in uscita il venerdì).

L’AI Act, come abbiamo già visto (vedi il #01), “suddivide” sistemi e modelli di intelligenza artificiale sulla base del rischio che essi possono presentare.

La scorsa settimana ci siamo occupati dei modelli e dei sistemi “con finalità generali”, ossia quelli maggiormente conosciuti e utilizzati, come Claude, Chat GPT, Gemini (vedi il #05).

I sistemi ad Alto Rischio

Il Regolamento definisce i sistemi ad alto rischio come quelli che presentano potenziali rischi significativi per la salute, la sicurezza o i diritti fondamentali delle persone.

La definizione fornita dall’articolo 6 si concentra su due aspetti specifici:

- Componente di sicurezza o prodotto soggetto a valutazione di conformità.

Un sistema di IA è considerato ad alto rischio se

- è destinato a essere utilizzato come componente di sicurezza di un prodotto: ciò significa che l’AI è integrata in un prodotto (ad esempio, una vettura, un dispositivo medico o un giocattolo) e svolge un ruolo fondamentale nel garantire la sicurezza del prodotto stesso. Oppure,

- è esso stesso un prodotto: in questo caso, l’AI è un software o un hardware stand-alone che viene venduto come prodotto indipendente e che è soggetto a una valutazione di conformità da parte di terzi.

- Valutazione di conformità da parte di terzi.

La valutazione di conformità è un processo obbligatorio per determinare se un prodotto soddisfa i requisiti di sicurezza previsti dalla normativa dell’Unione Europea. Questo processo viene effettuato da un organismo indipendente, chiamato “organismo notificato”.

Sono, poi, considerati ad alto rischio i sistemi (indicati nell’Allegato III del Regolamento) che possono essere applicati nei seguenti settori:

- Biometria:

- sistemi di identificazione biometrica remota, con esclusione degli utilizzi “più semplici” come quelli di riconoscimento del viso per accedere ai propri dispositivi; si tratta di sistemi riconoscono le persone a distanza, usando caratteristiche fisiche come il viso, le impronte digitali o la voce;

- sistemi di categorizzazione, ossia di classificazione di una persona in base a determinati criteri, biometrica;

- sistemi di riconoscimento delle emozioni. come ad esempio quelli che analizzano le espressioni facciali per valutare il livello di stress o di ansia di una persona, con implicazioni per la gestione del personale o l’accesso a servizi (sono esclusi dal novero i sistemi di sicurezza utilizzati, per esempio, per analizzare la stanchezza di un guidatore).

- Infrastrutture critiche: sistemi destinati a essere utilizzati come componenti di sicurezza nella gestione e nel funzionamento

- delle infrastrutture digitali critiche,

- del traffico stradale o

- nella fornitura di acqua, gas, riscaldamento o elettricità.

- Istruzione e formazione professionale:

-

- accesso,

- valutazione risultati,

- livello di istruzione,

- monitoraggio comportamenti.

- Lavoro:

- assunzione e selezione del personale,

- gestione del rapporto.

- Servizi e prestazioni essenziali:

- ammissione ai servizi,

- affidabilità creditizia,

- valutazione rischi e determinazione prezzi assicurazioni,

- servizi di emergenza.

- Attività di contrasto (utilizzo di sistemi AI per valutare):

- rischi per le vittime,

- strumenti di verifica,

- strumenti probatori

- rischio di o commissione reati.

- Migrazione, asilo e gestione del controllo delle frontiere:

- utilizzo poligrafi,

- valutazione rischi,

- esame domande e visti,

- riconoscimento persone.

- Amministrazione della giustizia e processi democratici:

- ricerca, interpretazione dei fatti e del diritto e applicazione legge,

- influenza sui referendum.

Alcune eccezioni

Vale la pena rilevare che un sistema che appartenga ad una delle categorie appena viste, non soggiace agli obblighi che stiamo per vedere se “non presenta un rischio significativo di danno per la salute, la sicurezza o i diritti fondamentali delle persone”.

Ciò accade quando il sistema è destinato a:

- eseguire un compito procedurale limitato, come svolgere un’azione specifica e ben definita, con un impatto minimo sulla valutazione o decisione finale: un sistema che automatizza l’inserimento di dati in un modulo di richiesta online;

- migliorare il risultato di un’attività umana precedentemente completata: assiste un’attività umana già compiuta, migliorandone l’efficienza o l’accuratezza, ma non sostituisce il giudizio umano, per esempio fornisce suggerimenti grammaticali durante la scrittura di un’email;

- rilevare schemi decisionali o deviazioni da schemi decisionali precedenti e non è finalizzato a sostituire o influenzare la valutazione umana precedentemente completata senza un’adeguata revisione umana; per esempio identifica schemi o anomalie nei dati, ma non prende decisioni autonome: risultati sono sottoposti a revisione e valutazione umana; un esempio potrebbe essere un sistema che analizza le immagini di radiografie per evidenziare potenziali anomalie, che vengono poi valutate da un medico.

- eseguire un compito preparatorio per una valutazione; ad esempio estrae dati o documenti legali per facilitare il lavoro di un consulente.

Come intuibile, queste eccezioni definiscono casi in cui sistemi di AI, potenzialmente ad alto rischio, non rientrano in questa categoria in quanto il loro impatto è limitato o il loro ruolo è di supporto alle attività umane.

Sarà dunque essenziale valutare attentamente le caratteristiche di ogni sistema per determinare la corretta classificazione e il rispetto degli obblighi previsti dal Regolamento.

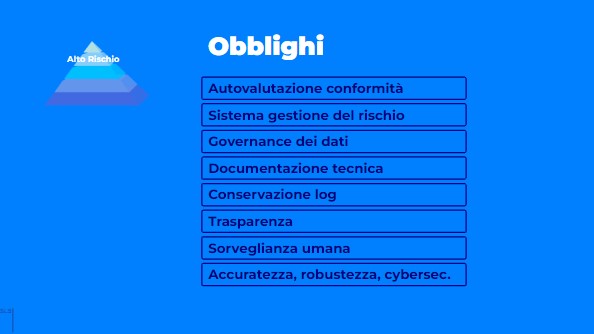

Gli obblighi dei fornitori di sistemi ad alto rischio

Il fornitore deve, innanzi tutto, documentare la valutazione del sistema prima dell’immissione sul mercato o della messa in servizio.

Si tratta di una

- autovalutazione di conformità con cui si certifica che si sono adempiuti gli obblighi che il Regolamento prevede.

Essi sono (v. artt. da 9 a 15):

- la messa in atto, documentata e mantenuta, di un sistema di gestione dei rischi; come noto, esistono molti approcci alla valutazione del rischio. Il testo fa esplicito riferimento ad un “sistema di gestione” e prevede i passaggi di:

- identificazione e analisi coerenti con gli scopi intesi del modello;

- stima e valutazione dei rischi in relazione agli usi intesi del modello secondo il prevedibile uso;

- valutazione di ulteriori possibili rischi che potrebbero sorgere sulla base di una analisi dei dati raccolti dopo la messa in commercio (ciò che all’evidenza impone un approccio iterativo e continuo, del risk management;

- l’adozione di misure di mitigazione appropriate.

- governance dei dati;

- documentazione tecnica;

- conservazione delle registrazioni;

- trasparenza e fornitura di informazioni ai deployer;

- sorveglianza umana;

- accuratezza, robustezza, cybersicurezza.

Di questi obblighi ci occuperemo la prossima settimana.

Anche per questo venerdì, basta!

Il riassunto (questa settimana di Claude 3.5.) di questo testo 😛:

Il testo tratta dei sistemi di intelligenza artificiale (IA) ad alto rischio secondo il Regolamento Europeo sull’IA (AI Act). I punti principali sono:

Definizione di sistemi ad alto rischio:

Sistemi che presentano rischi significativi per salute, sicurezza o diritti fondamentali.

Includono componenti di sicurezza di prodotti o prodotti soggetti a valutazione di conformità.

Settori considerati ad alto rischio (Allegato III del Regolamento):

Biometria

Infrastrutture critiche

Istruzione e formazione professionale

Lavoro

Servizi e prestazioni essenziali

Attività di contrasto

Migrazione, asilo e controllo delle frontiere

Amministrazione della giustizia e processi democratici

Eccezioni:

Sistemi che non presentano rischi significativi, come quelli che:

Eseguono compiti procedurali limitati

Migliorano risultati di attività umane già completate

Rilevano schemi decisionali senza sostituire il giudizio umano

Eseguono compiti preparatori per valutazioni

Obblighi dei fornitori di sistemi ad alto rischio:

Autovalutazione di conformità

Sistema di gestione dei rischi

Governance dei dati

Documentazione tecnica

Conservazione delle registrazioni

Trasparenza e informazioni ai deployer

Sorveglianza umana

Accuratezza, robustezza e cybersicurezza

Il testo sottolinea l’importanza di valutare attentamente ogni sistema per determinarne la corretta classificazione e il rispetto degli obblighi previsti dal Regolamento.

👾

p.s.: come sempre, ogni suggerimento o correzione, come sempre, è più che ben accetta!

👾 👾 👾 👾 👾

Questa newsletter si propone di esaminare le principali disposizioni in arrivo con un linguaggio semplice e chiaro, accompagnato il più possibile da esempi concreti.

Se sei interessato, iscriviti. 👾